La simulation numérique joue un rôle crucial dans la gestion des risques naturels en milieu alpin, notamment les éboulements et les avalanches. Des modèles 3D sophistiqués permettent aujourd’hui de simuler la propagation de ces mouvements de masse, offrant une meilleure compréhension des dangers potentiels et contribuant à la mise en place de mesures préventives efficaces.

Pouvez-vous nous dire exactement en quoi consistent les modèles 2D – 3D cités à l’occasion de la catastrophe de Blatten ? De quoi s’agit-il et pour quel usage ?

Il est important de noter que Fugro n’a pas été impliqué dans la modélisation de la catastrophe de Blatten, mais les approches de modélisation décrites ici sont consistantes avec celles utilisées dans le cadre d’études de risques similaires.

Image ©️Stemme

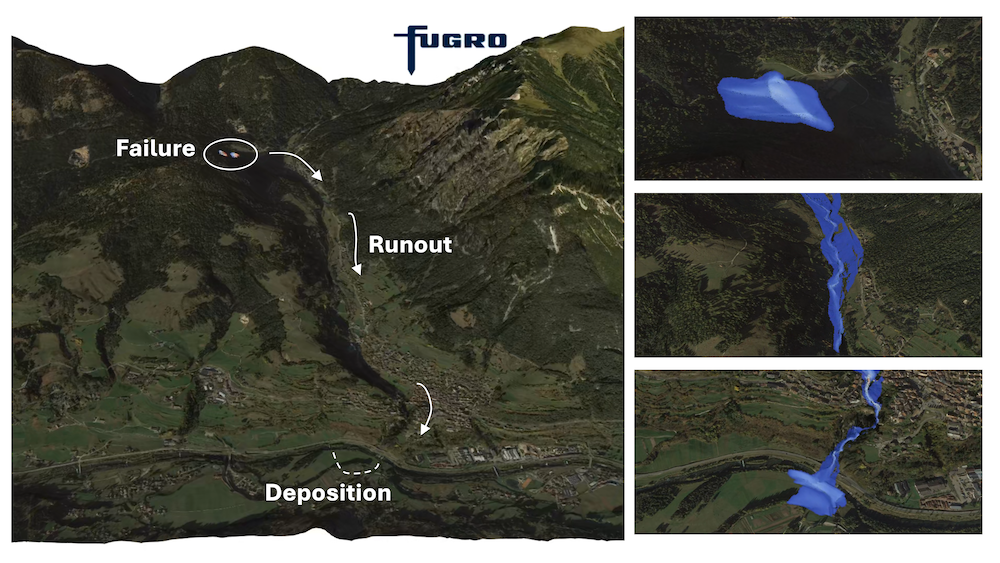

Les modèles 2D et 3D mentionnés lors de la catastrophe de Blatten font référence à des simulations utilisées pour appréhender et reconstruire la dynamique de mouvements de terrain sur un terrain complexe.

Les modèles prédictifs de propagation de tels mouvements de masse s’échelonnent sur une large gamme de complexité à la fois au niveau de l’approche algorithmique et de la finesse des modèles physiques constitutifs du mode d’écoulement de ces masses en mouvement, ce qu’on appelle la rhéologie. Le principe de la dynamique en jeu est pourtant simple et bien connu : la gravité est le moteur de l’écoulement, tandis que la friction interne et basale le freine au cours de sa propagation. Mais la manière dont s’écoule un mélange de roches, de sédiments, de glace et d’eau, tel que fût le cas au glacier de Birch surplombant Blatten, est incroyablement plus complexe que pour une eau claire relâchée à l’aval d’un barrage de retenue.

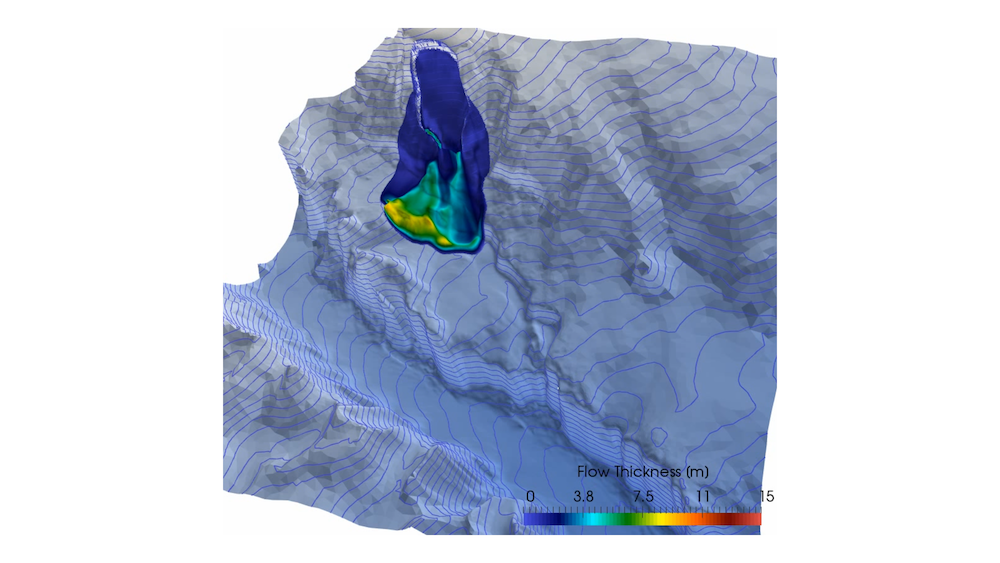

On parle de modèles 2D ou 3D de manière parfois ambiguë, car tous deux ambitionnent de prédire la propagation d’un mouvement sur une topographie qui est intrinsèquement tri-dimensionnelle. Plutôt qu’un modèle 2D, on se réfère à un modèle « moyenné sur la profondeur », lorsque l’épaisseur de l’écoulement est (très) faible par rapport aux dimensions horizontales de sa propagation, et ses propriétés sont moyennées sur la verticale. Il s’agit d’une approximation plus ou moins avisée suivant les cas. Historiquement, ces modèles ont eu le grand avantage d’être associés à un coût de calcul moindre, et de permettre ainsi la réalisation d’un grand nombre de simulations pour études de sensibilité sur divers paramètres incertains dans une perspective d’évaluation des risques. Ils ont été « calibrés » sur de nombreuses études de cas, et sont encore largement utiles et utilisés, pour évaluer une fourchette « haute » et « basse » des niveaux de risque pour un environnement donné.

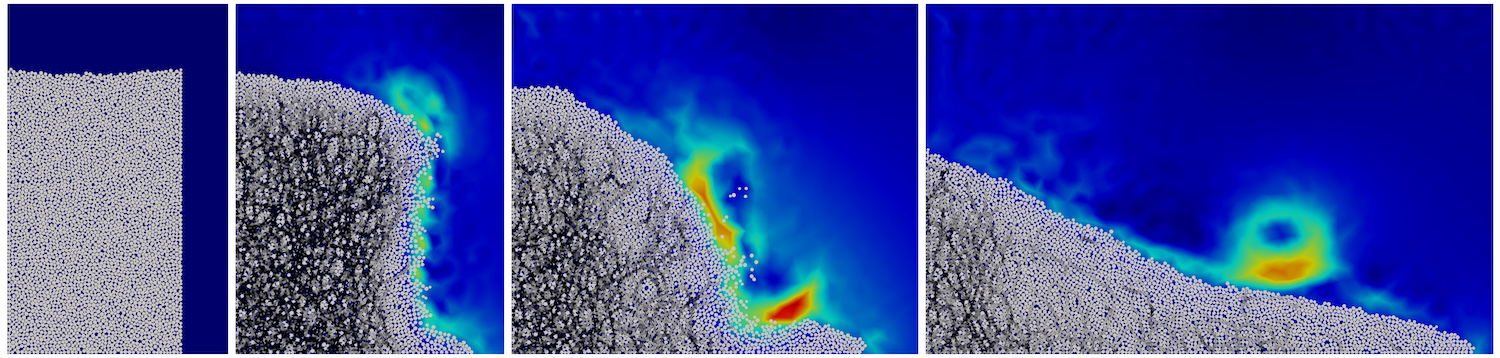

Les modèles réellement 3D visent à résoudre la structure verticale complète de l’écoulement. Elles fournissent un canevas algorithmique qui permet de rendre mieux compte de la stratification de l’écoulement, par exemple son cisaillement intense à la base, et la manière dont les différentes phases de l’écoulement (solide, liquide…) réagissent à cette stratification et interagissent entre elles. Il existe une large gamme de modèles 3D, notamment suivant qu’est adoptée une approche continue à maillage fixe (vision eulérienne), ou une approche lagrangienne où l’on suit le mouvement de pseudo-particules (par exemple l’approche MPM pour Material Point Method), voire une modélisation par éléments discrets réellement multiphasique (DEM-FEM) qui reste cependant, pour l’instant, largement confinée à la recherche académique (voir figure colonne granulaire).

Au cours de la dernière décennie, les progrès en puissance de calcul intensif et en algorithmique, ont rendu ces modèles 3D opérationnels pour des études de cas réels. Si c’est en apparence une petite révolution, cela permet surtout de s’affranchir assez largement du côté « complexité de résolution » de la simulation, pour se recentrer, plus en amont, sur une meilleure appréhension de la complexité du milieu naturel et ses lois de comportement, là où précisément se situent les incertitudes et enjeux majeurs de la modélisation.

L’usage de la simulation permettrait d’améliorer considérablement les prévisions et la gestion des risques en milieu alpin : pouvez-vous nous en dire plus ?

La gamme des outils de modélisation numérique permet maintenant d’alimenter la cartographie et la gestion des risques naturels en général, et en milieu alpin en particulier, de manière beaucoup plus intégrée, depuis l’échelle régionale jusqu’à une échelle très locale. Couplée à une capacité accrue et rapide d’acquisition et de traitement de données de terrain, ainsi que de monitoring en continu, elle permet de bâtir un réel « jumeau numérique » du milieu, outil puissant d’aide à la décision et à la gestion pour les acteurs de terrain et les autorités.

Pouvez-vous nous expliquer à quel moment (du risque naturel) et sur base de quels éléments (données), les experts peuvent effectuer une simulation numérique d’un risque en milieu alpin ?

Le lien avec la donnée est réellement crucial. Un modèle de simulation que l’on ne contraint pas avec des données fiables en entrée va produire des résultats trompeurs ou dénués de sens. Dans le cas de Blatten, la surveillance continue du glacier depuis 1993 a amené les experts à détecter les signes d’instabilité, croissants au cours des deux dernières semaines. Cela a permis d’anticiper la catastrophe, d’évacuer le village préventivement et de limiter les pertes humaines à une seule victime, la zone d’impact ayant été assez fidèlement anticipée. Moins de trois mois plus tard pourtant, le décrochement de blocs rocheux sur une paroi de la route de Chamonix, bien que moins spectaculaire et peu rapporté dans les médias, a pourtant fait plus de victimes. Cela souligne particulièrement les besoins en données géotechniques, géophysiques et hydrologiques fiables pour la caractérisation du milieu naturel. Contrairement à d’autres données, par exemple topographiques, qui peuvent maintenant être acquises assez simplement et rapidement (grâce à des drones, des données satellitaires, etc.), celles-ci nécessitent souvent des méthodes d’investigation plus fines, des prises d’échantillon, des essais de laboratoire, la prise en compte des incertitudes, de la variabilité spatiale, et de l’impact des changements climatiques. Les progrès dans le domaine de la science des données et leur traitement par des méthodes statistiques poussées sont aussi importants que ceux dans la simulation numérique proprement dite. La prise en compte des incertitudes est un élément crucial dans la gestion des risques.

Vu la multiplication des risques en milieu alpin, pensez-vous que la simulation numérique pourrait être un allié précieux ? Pouvez-vous citer d’autres exemples de risques naturels étudiés à l’aide de la simulation numérique ?

La simulation numérique a atteint un certain niveau de maturité, même si le domaine continue de faire l’objet de recherches importantes. C’est un outil incontournable dans toute gestion du risque naturel sur un territoire donné, qui permet notamment d’investiguer la réponse attendue dans un contexte changeant, pour différents scénarios, notamment avec une pression anthropique accrue et un contexte de changements climatiques. C’est aussi un des éléments de l’élaboration d’un « jumeau numérique ». Dans notre travail, nous appliquons des outils de simulation similaires, couplés à l’acquisition et au traitement de données de terrain, à d’autres types de risques naturels, comme la rupture de barrages de montagnes ou de barrages miniers (voir Figure de la reconstitution de la catastrophe de Stava, Italie, 268 victimes), les inondations subites, les laves torrentielles ou le risque de liquéfaction, ou même, en milieu marin, la modélisation de glissements de terrain sous-marin (voir figure glissement sous-marin) et de tsunami induit, ou les courants de turbidité…

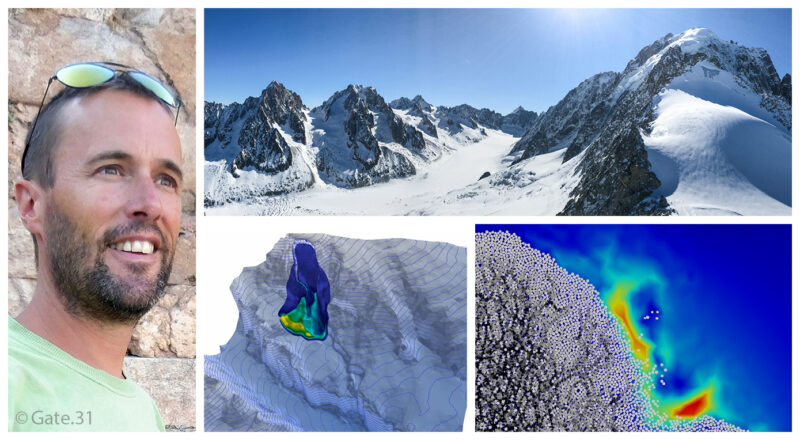

Au sujet de Benoit Spinewine

Benoit Spinewine est un ingénieur civil de l’UCLouvain. Sa thèse de doctorat concernait la modélisation des impacts sédimentaires (érosion/transport/dépôt) des crues extrêmes telles que résultant par exemple de la rupture de barrages ou de digues. Au sein de Fugro, leader mondial dans la collecte et l’interprétation de géo-données, il dirige la division de consultance en « Dynamic Modelling » qui se centre sur la caractérisation de risques naturels, en milieu côtier, marin et terrestre. Par ailleurs chargé de cours à l’UCLouvain, il est actuellement impliqué dans deux projets européens liés à cette thématique.